Die Eindrücke über Siri sind nach wie vor sehr gemischt. Während kürzlich veröffentlichte Tests Siri ein gutes Zeugnis ausstellen, sind unsere Eindrücke – und die unserer Community – mitunter konträr. Jetzt veröffentlicht Apple im hauseigenen Machine Learning Journal einige Details darüber, wie Siri dazugelernt hat.

Ein herber Knackpunkt vorweg: Die Verbesserungen gelten vor allem nur für die englische Version. Insofern erklären sich auch die oben angesprochenen Unterschiede zwischen Tests und unseren Erfahrungen.

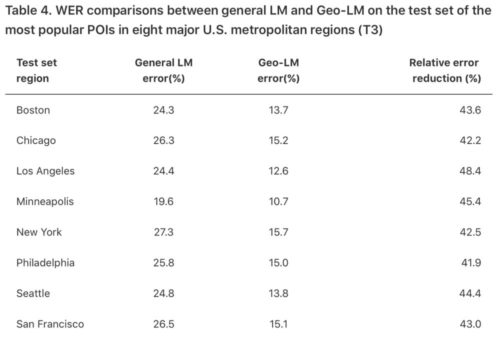

Mit Hilfe der gesammelten Daten stellt Apple mittlerweile kleinere Zonen zusammen. So sollen lokale Unterschiede bei der Aussprache besser unterschieden werden. Die USA wurde für diesen Zweck sehr fein granular aufgeteilt – in insgesamt 169 sogenannte Geo-LMs. Damit sollen 80 Prozent der US-Nutzer abgedeckt werden.

Machine Learning bringt Siri nach vorne

Die Ergebnisse scheinen überzeugend zu sein. Apple gibt in dem Blogeintrag aber auch an, dass es noch Potential nach oben gibt. Generische Sprachräume will der Konzern dennoch nicht abschaffen. Diese sind vor allem dann nötig, wenn sich Nutzer in anderen, ggf. nicht abgedeckten, Gebieten aufhalten.

So wünschenswert diese Verbesserung auch sein mag – nur die wenigsten die das hier lesen können, werden davon profitieren. Liebes Apple: Es gibt auch noch Nutzer außerhalb der USA. Sogar sehr viele,.. Auch diese haben dazu beigetragen, dass ihr euren Aktienrekord aufgestellt habt!