- Apples Standpunktwechsel: Sicherheitsbedenken bei der Bildanalyse im Staatsauftrag

- CSAM: Erneuter Druck auf Apple – für die Einführung

- Auch Drittanbieter sollen Maßnahmen gegen Kindesmissbrauch unterstützen

- Schutz gegen Kindesmissbrauch: Auch interne Kritik gegen Filter

- CSAM: Apple verschiebt Einführung

- EFF: Apple soll CSAM-Vorhaben völlig einstellen

Vergangene Woche hat Apple ein großes Paket mit Maßnahmen gegen Kindesmissbrauch vorgestellt. Während manche Initiativen ohne große Gegenwehr angenommen wurden, gelten andere als kontrovers. Jetzt zeigt sich: Apple möchte auch Drittanbieter-Apps in dieses Paket miteinbeziehen.

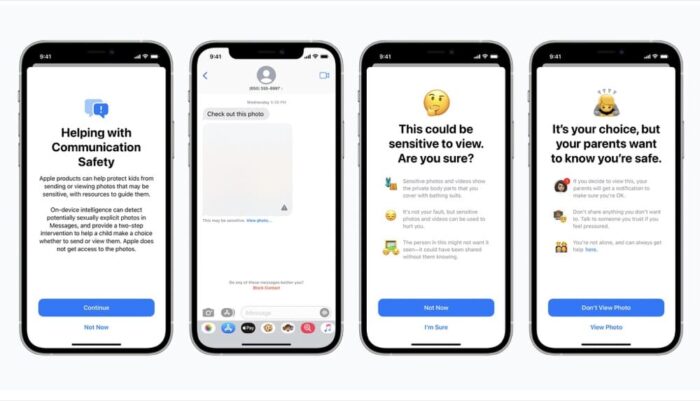

Beginnen wir mit einer Zusammenfassung – letzte Woche hat Apple ein Paket von Maßnahmen vorgestellt. Im Wesentlichen gibt es drei Säulen. Der Konzern möchte breiter auf Angebote zur Meldung von Vorfällen hinweisen. So informiert Siri künftig auch über Stellen, wo Nutzer Kindesmissbrauch melden können. Etwas kritischer wird es dann bei einer neuen Technik für iMessage. Diese soll explizite Inhalte identifizieren und vor dem Senden warnen – und im Zweifel Erziehungsberechtigte über den Vorgang informieren. Dazu kommt ein Filter für Fotos, hier sollen Bilder mit der NCMEC Datenbank abgeglichen werden. In diese Datenbank werden Hashes von kinderpornografischen Darstellungen gespeichert. Vorerst soll diese Technik nur in den USA zum Einsatz kommen.

What happens on your iPhone …

Gerade der Filter für die Fotos App wird von vielen Kritikern als ein absoluter Dammbruch gesehen, allen voran äußert sich Edward Snowden kritisch gegen diese Initiative. iCloud Fotos werden seit Langem durchsucht – mit der Untersuchung auf dem Gerät schon vor dem Upload bricht Apple aber eine heilige Grenze, die dem Konzern bisher äußerst wichtig war. Was auf dem iPhone passiert, bleibt damit nicht mehr auf dem iPhone.

Apple’s new iPhone contraband-scanning system is now a national security issue. They just openly admitted they have no answer for what to do when China comes knocking.

Hard to understate how disastrous this new system is for iPhone security. Tim Cook needs to intervene. https://t.co/eQHSH7KGx4

— Edward Snowden (@Snowden) August 9, 2021

Fragwürdige Ideen – für alle!

Unter objektiven Gesichtspunkten – was angesichts von Worten wie „Kindesmissbrauch“ zugegeben immer etwas schwierig ist – sind die Ideen und Umsetzungen von Apple auch weit über Marketingversprechen hinaus bestenfalls fragwürdig. In einer neuen FAQ geht der Konzern jetzt auf viele Fragen ein. Dort wird auch klar: Apple möchte diese Technologie nicht nur auf hauseigene Apps beschränken. Vielmehr sollen Drittanbieter ebenfalls darauf zugreifen.

Kindesmissbrauch: Wo kommen die NCMEC Daten eigentlich her?

Apple arbeitet hier mit der NCMEC zusammen, eine Datenbank von kinderpornografischen Inhalten. Übermittelt werden ausschließlich Hashes, die aus gemeldeten Inhalten generiert werden. Wie die Statistik der Herausgeber nun zeigt, meldet Apple dort auch Inhalte ein, bisher aber eher wenige. Spitzenreiter ist Facebook – was aufgrund ihrer Rolle auch nicht weiter verwunderlich ist. Immerhin betreibt Facebook das größte Social Network, aber keine eigene Hardware.