- Registriert

- 15.06.24

- Beiträge

- 26.619

Geschrieben von: Michael Reimann

Apple Intelligence, die KI-gestützte Benachrichtigungsfunktion, sorgt erneut für Diskussionen. Ein Vorfall in Großbritannien zeigt Schwächen in der Genauigkeit der Textzusammenfassungen. Die Technologie, die entwickelt wurde, um Nutzer:innen kurze und präzise Informationen zu liefern, hat in diesem Fall eine BBC-Schlagzeile falsch interpretiert und damit die Glaubwürdigkeit der KI infrage gestellt.

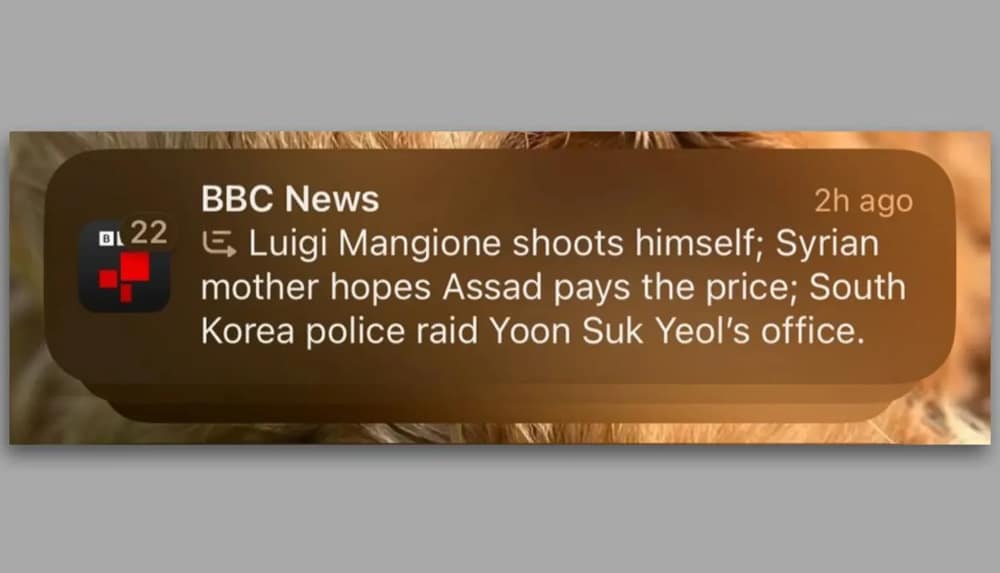

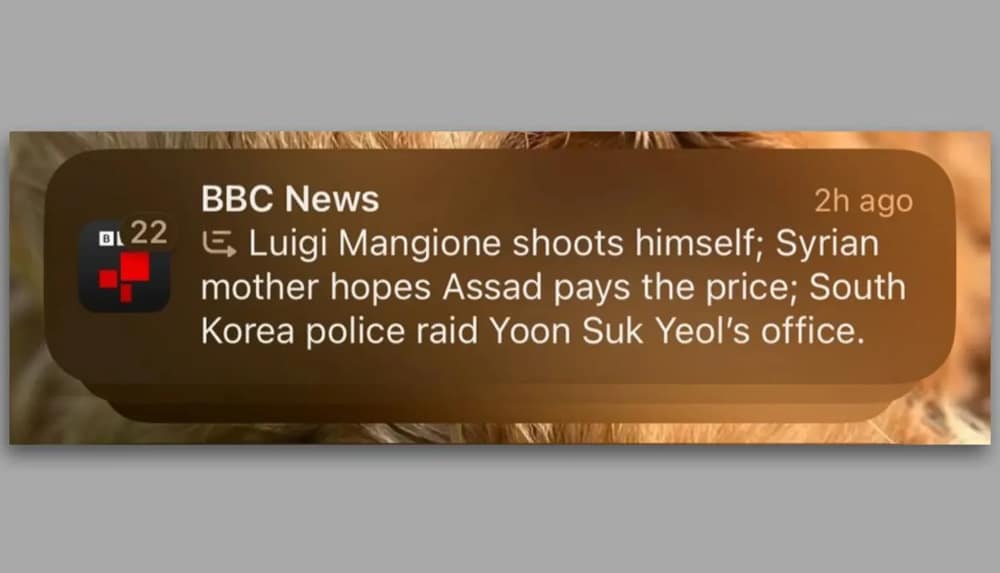

In der jüngsten Diskussion geht es um eine Benachrichtigung, die einen Artikel der BBC über den UnitedHealthcare-Shooting-Verdächtigen Luigi Mangione zusammenfasste. Die AI-generierte Meldung behauptete fälschlicherweise, dass Mangione sich selbst erschossen habe, was nicht den Fakten entsprach.

Der Fehler führte dazu, dass die BBC Apple kontaktierte, um die Angelegenheit zu klären und auf die Problematik hinzuweisen. Während andere Teile der Zusammenfassung korrekt waren, zeigt dieser Vorfall die Herausforderungen, denen Apple Intelligence beim Verstehen von Kontext und Nuancen begegnet. Solche Fehler könnten Nutzer:innen in die Irre führen und das Vertrauen in Nachrichtenquellen beeinträchtigen.

Die Problematik bei der Zusammenfassung der BBC-Meldung ist nicht der erste Fehler, der bei Apple Intelligence auffällt. Frühere Beispiele umfassen eine Fehldeutung eines Kommentars wie „Die Wanderung hat mich fast umgebracht“ als „versuchter Selbstmord“ oder die Fehlinterpretation einer Ring-Kamera-Benachrichtigung als ernsthafte Sicherheitsgefahr.

Diese Vorfälle verdeutlichen die Grenzen der natürlichen Sprachverarbeitung (Natural Language Processing, NLP). Insbesondere bei komplexen oder sensiblen Inhalten fehlt es der Technologie noch an Präzision.

Falls Du die Apple-Intelligence-Benachrichtigungen als unzuverlässig empfindest, kannst Du die Funktion anpassen oder deaktivieren. Gehe dazu wie folgt vor:

Apple Intelligence ist derzeit noch nicht in der EU verfügbar. Apple hat bestätigt, dass das KI-System im April auch nach Deutschland kommt und in deutscher Sprache verfügbar ist.

Apple positioniert Intelligence als Schlüsseltechnologie für eine effizientere Informationsverarbeitung. Doch Vorfälle wie diese zeigen den Verbesserungsbedarf deutlich. Eine stärkere Kontextanalyse und verbesserte Validierungsprozesse könnten künftige Fehler reduzieren.

Apple steht vor der Aufgabe, das Vertrauen in seine KI zu stärken. Trotz der aktuellen Kritik bleibt das Potenzial der Technologie enorm. Mit gezielten Verbesserungen kann Apple Intelligence zu einem zuverlässigen Tool werden, das Nutzer:innen tatsächlich unterstützt.

Via: The Verge / BBC

Bild: BBC

Im Magazin lesen....

Apple Intelligence, die KI-gestützte Benachrichtigungsfunktion, sorgt erneut für Diskussionen. Ein Vorfall in Großbritannien zeigt Schwächen in der Genauigkeit der Textzusammenfassungen. Die Technologie, die entwickelt wurde, um Nutzer:innen kurze und präzise Informationen zu liefern, hat in diesem Fall eine BBC-Schlagzeile falsch interpretiert und damit die Glaubwürdigkeit der KI infrage gestellt.

Fehlinterpretation eines BBC-Artikels

In der jüngsten Diskussion geht es um eine Benachrichtigung, die einen Artikel der BBC über den UnitedHealthcare-Shooting-Verdächtigen Luigi Mangione zusammenfasste. Die AI-generierte Meldung behauptete fälschlicherweise, dass Mangione sich selbst erschossen habe, was nicht den Fakten entsprach.

Der Fehler führte dazu, dass die BBC Apple kontaktierte, um die Angelegenheit zu klären und auf die Problematik hinzuweisen. Während andere Teile der Zusammenfassung korrekt waren, zeigt dieser Vorfall die Herausforderungen, denen Apple Intelligence beim Verstehen von Kontext und Nuancen begegnet. Solche Fehler könnten Nutzer:innen in die Irre führen und das Vertrauen in Nachrichtenquellen beeinträchtigen.

Wiederholte Probleme bei Apple Intelligence

Die Problematik bei der Zusammenfassung der BBC-Meldung ist nicht der erste Fehler, der bei Apple Intelligence auffällt. Frühere Beispiele umfassen eine Fehldeutung eines Kommentars wie „Die Wanderung hat mich fast umgebracht“ als „versuchter Selbstmord“ oder die Fehlinterpretation einer Ring-Kamera-Benachrichtigung als ernsthafte Sicherheitsgefahr.

Diese Vorfälle verdeutlichen die Grenzen der natürlichen Sprachverarbeitung (Natural Language Processing, NLP). Insbesondere bei komplexen oder sensiblen Inhalten fehlt es der Technologie noch an Präzision.

Einstellungsmöglichkeiten für Nutzer:innen

Falls Du die Apple-Intelligence-Benachrichtigungen als unzuverlässig empfindest, kannst Du die Funktion anpassen oder deaktivieren. Gehe dazu wie folgt vor:

- Öffne die Einstellungen auf Deinem iPhone.

- Wähle Mitteilungen.

- Gehe zu Mitteilungen zusammenfassen, um Apps zu verwalten oder die Funktion komplett abzuschalten.

Apple Intelligence ist derzeit noch nicht in der EU verfügbar. Apple hat bestätigt, dass das KI-System im April auch nach Deutschland kommt und in deutscher Sprache verfügbar ist.

Herausforderungen und Potenziale für die Zukunft

Apple positioniert Intelligence als Schlüsseltechnologie für eine effizientere Informationsverarbeitung. Doch Vorfälle wie diese zeigen den Verbesserungsbedarf deutlich. Eine stärkere Kontextanalyse und verbesserte Validierungsprozesse könnten künftige Fehler reduzieren.

Apple steht vor der Aufgabe, das Vertrauen in seine KI zu stärken. Trotz der aktuellen Kritik bleibt das Potenzial der Technologie enorm. Mit gezielten Verbesserungen kann Apple Intelligence zu einem zuverlässigen Tool werden, das Nutzer:innen tatsächlich unterstützt.

Via: The Verge / BBC

Bild: BBC

Im Magazin lesen....